«Risques pour l'humanité» : Musk appelle à freiner la recherche sur les IA les plus avancées

- Avec AFP

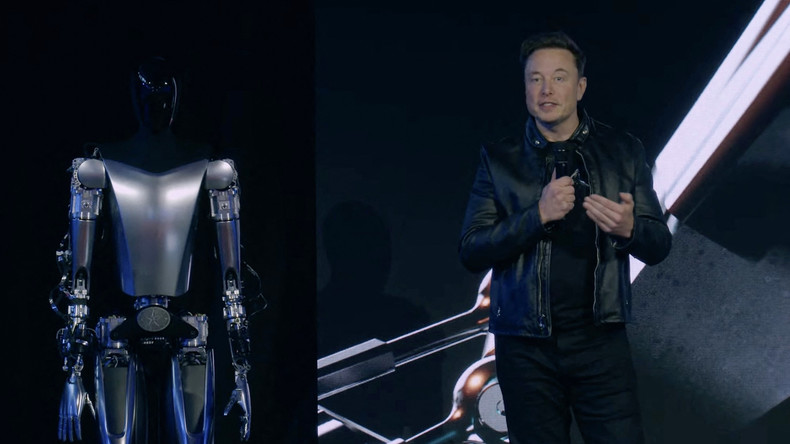

© Tesla Source: AFP

© Tesla Source: AFPElon Musk et des centaines d'experts veulent une pause de six mois dans la recherche sur les intelligences artificielles (IA) plus puissantes que ChatGPT 4, le modèle d'OpenAI lancé mi-mars, en pointant «des risques majeurs pour l'humanité».

Les signataires d'une pétition parue le 29 mars sur le site futureoflife.org réclament un moratoire jusqu'à la mise en place de systèmes de sécurité, dont de nouvelles autorités réglementaires dédiées, la surveillance des systèmes d'IA, des techniques pour aider à distinguer le réel de l'artificiel et des institutions capables de gérer «les perturbations économiques et politiques dramatiques [en particulier pour la démocratie] que l'IA provoquera».

📢 We're calling on AI labs to temporarily pause training powerful models!

— Future of Life Institute (@FLIxrisk) March 29, 2023

Join FLI's call alongside Yoshua Bengio, @stevewoz, @harari_yuval, @elonmusk, @GaryMarcus & over a 1000 others who've signed: https://t.co/3rJBjDXapc

A short 🧵on why we're calling for this - (1/8)

La pétition réunit des personnalités qui ont déjà publiquement exprimé leurs craintes envers des IA incontrôlables qui surpasseraient l'être humain, dont Elon Musk, propriétaire de Twitter et fondateur de SpaceX et de Tesla, et Yuval Noah Harari, l'auteur de Sapiens : Une brève histoire de l'humanité.

Egalement signataire, Yoshua Bengio, pionnier canadien de l'IA, a exprimé ses préoccupations, lors d'une conférence de presse virtuelle à Montréal : «Je ne pense pas que la société est prête à faire face à cette puissance-là, au potentiel de manipulation par exemple des populations qui pourrait mettre en danger les démocraties», a-t-il estimé.

«La société a besoin de temps pour s'adapter»

«Il faut donc prendre le temps de ralentir cette course commerciale qui est en route [...] comme nous l'avons fait pour l'énergie et les armes nucléaires», a-t-il ajouté, appelant à discuter de ces enjeux au niveau mondial.

Sam Altman, patron d'OpenAI, concepteur de chatGPT, a lui-même reconnu être «un petit peu effrayé» par sa création si elle était utilisée pour de «la désinformation à grande échelle ou des cyberattaques». «La société a besoin de temps pour s'adapter», avait-il déclaré à ABCNews mi-mars.

«Ces derniers mois ont vu les laboratoires d'IA s'enfermer dans une course incontrôlée pour développer et déployer des cerveaux numériques toujours plus puissants, que personne – pas même leurs créateurs – ne peut comprendre, prédire ou contrôler de manière fiable», estiment les signataires de l'appel.

«Devons-nous laisser les machines inonder nos canaux d'information de propagande et de mensonges ? Devrions-nous automatiser tous les emplois, y compris ceux qui sont gratifiants ? Devons-nous développer des esprits non humains qui pourraient un jour être plus nombreux, plus intelligents, nous rendre obsolètes et nous remplacer ? Devons-nous risquer de perdre le contrôle de notre civilisation ? Ces décisions ne doivent pas être déléguées à des leaders technologiques non élus», concluent-ils.

Devons-nous laisser les machines inonder nos canaux d'information de propagande et de mensonges ?

Les signataires comprennent aussi le cofondateur d'Apple Steve Wozniak, des membres du laboratoire d'IA de Google DeepMind, le patron de Stability AI Emad Mostaque, concurrent d'OpenAI, ainsi que des experts en IA et universitaires américains, ingénieurs cadres de Microsoft, groupe allié de OpenAI.